분류분석은 데이터셋의 특성에 따라 신뢰할 수 있는 지표가 다름

ex) 암환자 진단 Imbalance Data set의 경우 Recall이 신뢰할 수 있는 지표

ROC : 모든 분류 임계값에서 분류 모델의 성능을 보여주는 그래프

TPR(True Positive Rate)

- ROC 그래프에서 Y축

- Recall(참 양성 비율) : 클수록 높은 성능

FPR(False Positive Rate)

- ROC 그래프에서 X축

- 허위 양성 비율 : 클수록 낮은 성능

Threshold

- 임계값

- 분류분석에서 모델이 반환한 값 기반 Positive/Negative를 판단하는 기준 값

- Threshold 값에 따라 TPR/FPR 값이 양의 상관관계를 가지고 변화됨

분류분석에서 Threshold의 Min/Max

1) Min Threshold = 0 인 경우

- 모든 데이터를 Positive로 판정

==> TPR = 1, FPR = 1

2) Max Threshold = 1 인 경우

- 모든 데이터를 Negative로 판정

==> TPR = 0, FPR = 0

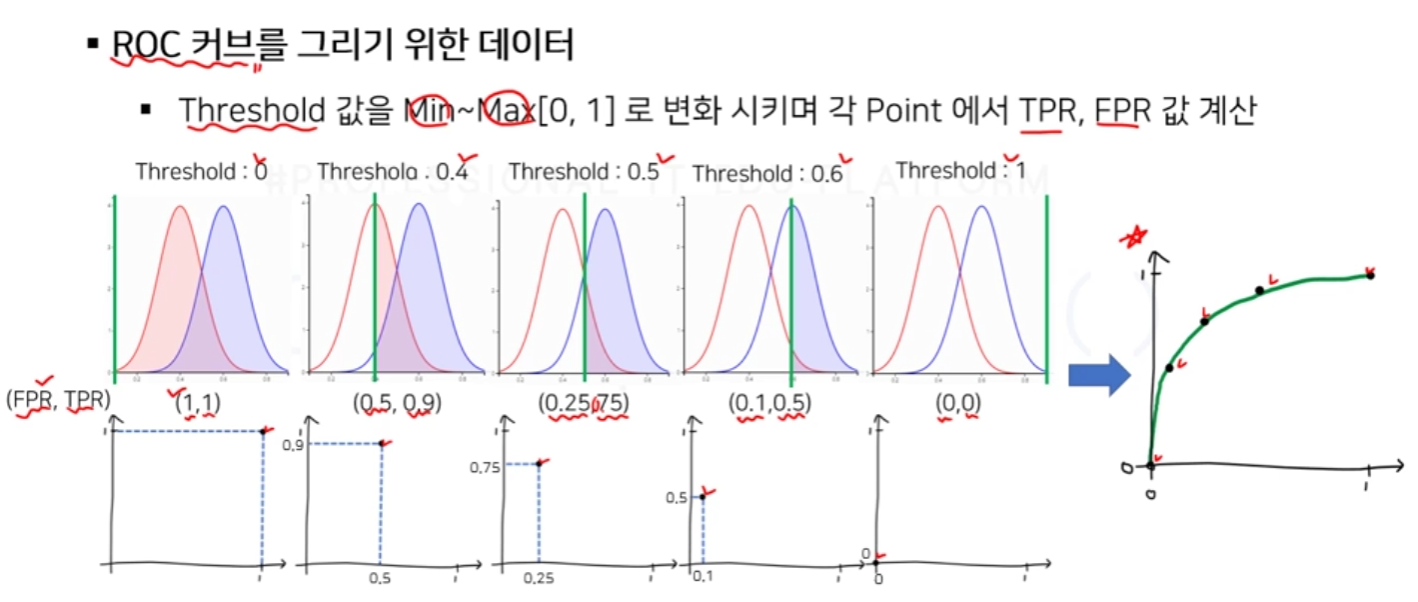

ROC 커브를 그리기 위한 데이터

- Threshold 값을 Min부터 Max까지[0, 1] 변화시키며, 각 Point에서 TPR, FPR 값 계산

'프로젝트 > 코드프레소 체험단' 카테고리의 다른 글

| 파이썬으로 구현하는 머신러닝 : 분류분석 - ROC 커브와 AUC 실습 (0) | 2022.01.23 |

|---|---|

| 파이썬으로 구현하는 머신러닝 : 분류분석 - AUC 지표를 통한 모델 성능분석 (0) | 2022.01.23 |

| 파이썬으로 구현하는 머신러닝 : 분류분석 - 로지스틱 회귀 실습1 (0) | 2022.01.22 |

| 파이썬으로 구현하는 머신러닝 : 분류분석 - 분류 분석을 위한 성능 지표 (0) | 2022.01.21 |

| 파이썬으로 구현하는 머신러닝 : 분류분석 - 분류의 이해 (0) | 2022.01.20 |